המערכת החדשה של אפל לזיהוי תכנים פדופיליים מעוררת סערה

אפל הכריזה על מערכת חדשה, שתופעל מאוחר יותר השנה, המזהה תכנים הקשורים להתעללות מינית בילדים בחשבונות של משתמשים, שעוררה מיד תגובות מצד ארגוני פרטיות ומומחי אבטחה ● בעקבות הסערה שחוללה, הודיעה אפל על שינויים בתוכנית

אפל הכריזה ביום ה' בלילה על תוכנית חדשה להגנה על ילדים, שבמסגרתה פיתחה שלושה כלים לזיהוי תכנים הקשורים להתעללות מינית בילדים, שיופעלו מאוחר יותר השנה.

החברה תשיק תוכנה חדשה, שתסרוק תמונות המאוחסנות בחשבונות iCloud של המשתמשים במטרה לאתר תכנים המוגדרים כהתעללות מינית בילדים, שהחברה מכנה CSAM (ר"ת Child Sexual Abuse Material), ולדווח על כך לרשויות המתאימות. התוכנה גם תסרוק את התמונות שבמכשירי iPhone ו-iPad והן ינותחו לפני שהן מועלות ל-iCloud. תכונה נוספת תנתח תמונות שנשלחות לילדים או מתקבלות על ידי ילדים באפליקציית Messages במטרה לזהות האם הן קשורות לתוכן האמור. גם העוזרת הקולית Siri תקבל תכונה חדשה, שתאפשר התערבות כאשר משתמשים מחפשים תכנים בנושא התעללות מינית.

אפל הודיעה בתחילה, כי אם תזהה תכנים של התעללות מינית של ילדים בחשבון של משתמש, סוקרי החברה יבדקו קודם את התכנים ובמקרה הצורך ידווחו למרכז לילדים נעדרים וקורבנות ניצול, NCMEC (ר"ת National Center for Missing and Exploited Children), שעובד מול סוכנויות אכיפת החוק. החברה שינתה בהמשך את גישתה, והודיע כי לא תדווח לרשויות (ראו בהמשך).

אפל הסבירה, כי איתור התמונות ייעשה באמצעות השוואה שלהן עם בסיס נתונים של חומרי CSAM מוכרים שהיא מקבלת מהמרכז, תוך שימוש בטכנולוגיה שהחברה מכנה NeuralHash, המנתחת את התמונות וממירה אותן למפתח מגובב, או צירוף ייחודי של מספרים. המפתח הזה מושווה לבסיס הנתונים תוך שימוש בקריפטוגרפיה. התהליך הזה, ציינה אפל, מאפשר גם זיהוי של תמונות שלא תואמות את בסיס הנתונים.

אפל ציינה כי המערכת הצליחה לפעול עם רמת שגיאות של פחות מאחת למיליארד בשנה, וכי היא מגינה על פרטיות המשתמש. "אפל רק סורקת את התמונות בחשבונות התמונות של המשתמשים ב-iCloud ובודקת אם יש להם אוסף של חומרים הקשורים להתעללות בילדים", ציינה החברה. "גם במקרים אלה, אפל מאתרת רק תמונות שתואמות לחומרים מוכרים".

משתמש שחושב כי החשבון שלו סומן בטעות, יכול להגיש לחברה ערעור.

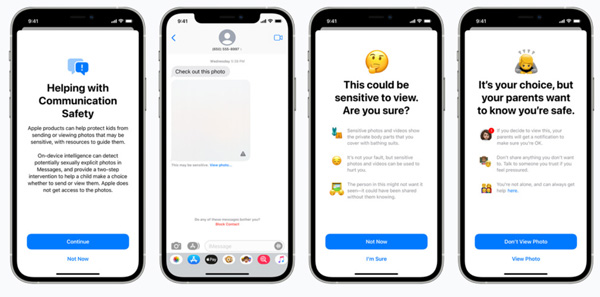

הכלי השני, הקשור ל-Massages, הוא אופציונלי, וההורים יכולים לאפשר אותו במכשירים של ילדיהם. המערכת בודקת נוכחות של תמונות עם תוכן מיני בין התמונות שמתקבלות או מיועדות לשליחה. אם מתקבלת למכשיר תמונה עם תוכן מיני, היא תטושטש ויהיה צורך ללחוץ על כפתור נוסף כדי לצפות בה. אם הילד אכן יצפה בה – ההורה יקבל על כך התראה. בדומה לכך, אם הילד ינסה לשלוח תמונה עם תוכן מיני, תופיע אזהרה על המסך, וההורה יקבל התראה.

התוכנה תזהיר את הילדים ואת הוריהם כאשר הם מקבלים או שולחים תמונות עם תוכן מיני. מקור: אפל

התכונה הזאת, לדברי אפל, מנתחת את התמונה במכשיר עצמו, והחברה לא יכולה לצפות בתוכן ההודעות. התכונה תואמת לשירות iMassage ולפרוטוקולים נוספים, כמו הודעות MMS.

לבסוף, הכלי השלישי, שהוסף ל-Siri, כולל שתי תכונות. הראשונה מאפשרת למערכת להגיב לשאלות על דיווח בנושאי ניצול מיני של ילדים ולספק למשתמשים מידע כיצד לדווח על כך. התכונה השנייה מזהירה משתמשים שעורכים חיפושים של חומרים הקשורים להתעללות בילדים.

הכלים החדשים ב-Massages וב-Siri יגיעו למערכות ההפעלה של ה-iPhone, ה-iPad, ה-Mac וה-Apple Watch, מסרה אפל.

Siri תסייע לדווח על CSAM ותתריע על חיפושי תוכן לא ראוי. מקור: אפל

הסערה בעקבות ההכרזה

ההודעה של אפל עוררה סערה גדולה בקרב חוקרי אבטחה וקבוצות פרטיות שונות, שהעלו חששות לפגיעה בפרטיות המשתמשים, ובייחוד מצד חברה שחרתה על דגלה את נושא השמירה על פרטיות. הארגון להגנה על חופש האזרח כינה את היוזמה של אפל "סטירה מצלצלת למשתמשים שסומכים על ההובלה של החברה בתחומי הפרטיות והאבטחה". המתריע הידוע אדוארד סנאודן הגיב ואמר, כי "לא משנה עד כמה טובות הכוונות שלה, אפל תפעיל עם הכלים האלה מעקב המוני בעולם כולו. אם הם יכולים לסרוק ולאתר פורנוגרפיית ילדים כיום, הם יוכלו לאתר כל דבר מחר".

המתנגדים העלו חששות על ניצול לרעה של המערכת, למשל, באמצעות שליחה מכוונת של תוכן אסור למשתמש תמים, ובכך לגרום לתיוגו כבעל תכנים פדופיליים ולדיווח שגוי עליו לרשויות החוק. תסריטים אחרים, לדבריהם, יכולים להיות, למשל, מעקב של ממשלות אחרי מתנגדי משטר או מורדים.

לעומתם, היו גם תגובות חיוביות, כמו זו של ג'ון קלארק, נשיא ומנכ"ל NCMEC, ששיבח את אפל על היוזמה, וציין, כי "ההרחבה של ההגנה על ילדים היא 'משנה משחק'. אנשים רבים כל כך משתמשים במוצרי אפל, ואמצעי הבטיחות החדשים האלה הם בעלי פוטנציאל של הצלת חיים עבור ילדים שהתמונות המזוויעות שלהם מופצות בחומרים של התעללות מינית בילדים".

תגובת אפל לחששות

במענה לתגובות ולחששות שהועלו, פרסמה אפל אתמול (ו') פרטים נוספים על תוכניותיה. החברה אמרה, כי המערכת לזיהוי CSAM תוגבל בתחילה לארצות הברית בלבד, וכדי למנוע ניצולה לרעה על ידי מדינות מסוימות, החברה מבטיחה כי היא תשקול הרחבה גלובלית של המערכת על בסיס בדיקה קפדנית של כל מדינה ומדינה לאחר שתקיים הערכה משפטית. אפל לא סיפקה לוח זמנים של הפצת המערכת בעולם ואם היא בכלל שוקלת זאת.

עוד ציינה אפל, כי השכבה הראשונה של ההגנה היא איזשהו סף חסוי לפני שמשתמש מסומן כבעל תמונות לא ראויות. גם אם הסף נחצה, התוכן מועבר לבדיקת ידנית של הסוקרים, שמהווה מחסום נוסף שמאשר את קיומם או אי קיומם של תמונות CSAM. בנוסף, היא לא תדווח על המשתמשים המסומנים למרכז ה-NCMEC או לרשויות האכיפה, והמערכת תמשיך לתפקד כפי שתוכננה.

אפל הדגישה גם תגובות של תומכי המערכת, שמשבחים אותה על מאמציה להילחם בניצול של ילדים, בהן תגובתו של סטיבן בלקאם, מנכ"ל המכון לבטיחות המשפחה ברשת, שציין, כי "אנו תומכים בהתפתחות המתמדת בגישתה של אפל לבטיחות ילדים ברשת. בהתחשב באתגרים שמולם מתמודדים ההורים בהגנת הילדים שלהם ברשת, חשוב שחברות הטק ימשיכו עוד ועוד לשפר את כלי הבטיחות שלהן בתגובה לסיכונים חדשים ולנזקים ריאליים".

אפל מודה שאין פתרון קסם שיכול למנוע ניצול לרעה של המערכת, אך לדבריה היא מחויבת להשתמש במערכת רק לצורך זיהוי של תמונות CSAM ידועות.

פרופ' בני פנקס, שעומד בראש מרכז הסייבר של אוני' בר-אילן, ערך ביקורת למערכת לבקשת אפל. כמומחה לקריפטוגרפיה וכמי שמכיר היטב את המערכת החדשה, שהופכת לכלי למאבק בהצפנה, מסר, כי "המערכת החדשה של אפל מספקת איזון טוב בין פרטיות לשמירה על תועלת הציבור, ובמקרה זה ילדים. היא מבטיחה רמה גבוהה של פרטיות עבור הגולשים, לצד יכולת מרשימה לזהות תוכן פדופילי".

תגובות

(0)