הפתרון המשולב של Run:ai ו-רד האט לניהול משאבי הבינה המלאכותית

לקראת האירוע של רד האט עבור מגזר הביטחון, ארז קירזון, מהנדס פתרונות ראשי ב-Run:ai, מספר על חשיבות שיתוף הפעולה עם ענקית הקוד הפתוח והיתרונות עבור הארגונים הביטחוניים

אתגרים בפיתוח מודלים של בינה מלאכותית

היכולת לרתום את הבינה המלאכותית וכוחה הפכה לכלי חשוב עבור ארגונים בכלל, ובסביבה הביטחונית בפרט. ברור כי לבינה מלאכותית יש את הפוטנציאל להשיג ערך באמצעות ייעול תהליכים, אולם פיתוח של מודלים נותר משימה מאתגרת ומצריך שימוש רב במעבדים ותשתיות מחשוב.

מהנדסי בינה מלאכותית ו-MLOps בתחום הביטחוני מתקשים לעיתים קרובות לפרוס מודלים על מעבדי GPU וכתוצאה מכך, לחוקרים אין תמיד גישה מספקת למשאבי המחשוב. מודלים של בינה מלאכותית מביאים לדרישות ואתגרים חדשים, שלא תמיד עולים בקנה אחד עם שיטות העבודה המומלצות המסורתיות לפריסת יישומים, בעוד שניהול מעבדי GPU בשלב ה-production של המודלים מביא לאתגרים נוספים הדורשים כלים ותהליכי עבודה חדשים.

הפתרון של Run:ai

הטכנולוגיה של Run:ai מאפשרת לארגונים ביטחוניים המפתחים מודלים של בינה מלאכותית לנצל טוב יותר את משאבי מעבדי ה-GPU שלהם ולחסוך בעלויות העצומות הכרוכות בבניית המודלים ובהמשך, בהרצת היישומים המבוססים עליהם, כמו צ'טבוטים.

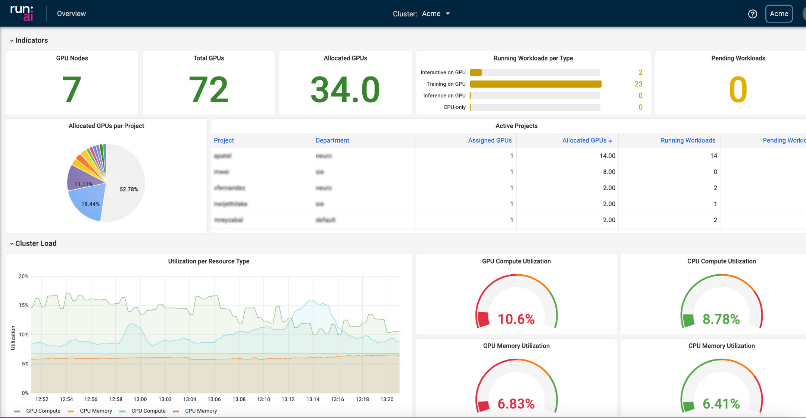

פלטפורמת ה-GPU Orchestration של Run:ai מאפשרת לצוותים לאגד (Pool) ולתזמן (Schedule) את משאבי המחשוב שלהם (GPUs). יכולת זו מאפשרת גמישות רבה יותר בחלוקת משאבים ומספקת גישה מהירה לכוח המחשוב, בהתאם לצרכים הייחודיים של כל שלב במחזור החיים של פיתוח המודלים.

יכולת זו, התומכת במערכי מחשוב לוקאליים (On-Prem), בענן ובסביבות היברידיות – מקצרת את זמני הפיתוח ומאפשרת לצוותי המחקר והפיתוח להקדיש יותר זמן לפיתוח מודלים ולבזבז פחות זמן על מכשולים כמו גישה לכוח מחשוב, תזמון של עבודות למידה, חיבוריות וכדומה, ובסופו של דבר – להאיץ את קצב שחרור המודלים לשוק.

הפלטפורמה של Run:ai מספקת גם מענה למפתחים, על ידי הנגשה נוחה יותר דרך כלי ממשק GUI ועבודה עם CLI. לדוגמה: היכולת להריץ מחברות ג'ופיטר ישירות מהפלטפורמה בצורה קלה ובנוסף מעבר לעבודות אימון מורכבות. יתרון נוסף של Run:ai – היכולת לחלק כל מעבד GPU, דבר המאפשר, למשל, להריץ מספר רב של מחברות על אותו GPU, למקסם את החומרה ולחסוך כסף לארגון.

Run:ai Cluster

האינטגרציה של Red Hat OpenShift ו-Run:ai

חברת Run:ai עבדה בצמוד עם חברת רד האט העולמית לצורך קבלת אישור להיכנס לחנות האפליקציות של OpenShift – Operatorhub. כיום, כל חברה שיש לה Red Hat OpenShift יכולה להתקין את מערכת Run:ai בקלות.

לאחר ההתקנה, הארגון ייהנה מריכוז ותזמון משאבי המחשוב (GPUs) באופן אוטומטי. האינטגרציה של Run:ai ו-Red Hat OpenShift ממקסמת את ניצול המשאבים, מפחיתה בזבוז GPU סרק ובסופו של דבר, מובילה לניסויים מהירים יותר, מודלים מדויקים יותר וערך עסקי מוגבר מבינה מלאכותית.

חשיבות הפתרונות המשולבים עבור המגזר הביטחוני

ארגון ביטחוני העובד היום עם Red Hat OpenShift דורש אינטגרציה מלאה בסביבה הקיימת והעובדה שהחברות כבר בדקו יחד את השילוב, מספקת שקט ארגוני. בנוסף, התמיכה של Run:ai בסביבת AIR-GAPPED מבוססת OpenShift משמרת את רמת האבטחה הגבוהה בארגון.

המגמות בשוק

המהפכה בתחום הג'נרטיב AI תביא עימה עלייה בפיתוח מספר רב של מודלים של LLM הפועלים רבות בסביבה הביטחונית, המצריכים שימוש מאסיבי בכוח המעבדים הגרפיים (GPUs), ואנחנו כבר מרגישים שיש שינוי בשוק מבחינת עלייה בביקוש לפתרון של Run:ai.

אנחנו עתידים לראות את עולם ה-Edge מתפתח יותר, מודלים ירוצו "קרוב" לשטח, כאשר כוח העיבוד יתבצע מרחוק.

ניתן למצוא מידע נוסף על Run:ai באתר החברה Run.ai וליצור קשר דרך [email protected]

לקראת כנס Defence OPEN-TECH Event 2023

לקראת כנס Defence OPEN-TECH Event 2023