OpenAI מנסה לעצב את כללי התנהגות ה-AI שלה לעתיד

המסמך בשם Model Spec, המנסח זאת, הגיע אחרי שחוקרת הבינה המלאכותית המובילה - שמאחורי הכלים המרשימים ChatGPT ו-DALL·E 3 - גילתה כי עם כוח רב באה אחריות גדולה ● כעת היא החלה מתאמצת לרסן את הטכנולוגיה שלה

חוקרת ומפתחת הבינה המלאכותית הג'נרטיבית, OpenAI, הציגה באחרונה מסמך עקרונות עבודה חדש שנקרא Model Spec (בתרגום חופשי 'מנעד המודלים') – המתאר כיצד היא מתכוונת שדגמי הבינה המלאכותית שלה יתנהגו. יוזמה זו מסמלת צעד משמעותי לקראת הבטחת החוקיות, הבטיחות והיעילות של כליה של החברה Sora, ChatGPT ו-DALL·E 3, בין השאר.

"ה-Model Spec הוא מסמך שמפרט כיצד אנו רוצים שהמודלים שלנו יתנהגו", הסבירה OpenAI באתר האינטרנט שלה. היא הרחיבה על מטרת המסמך וציינה: "Model Spec כולל עקרונות, כללים והתנהגויות ברירת מחדל, שבהם נשתמש כדי להנחות את הפיתוח והפריסה של המודלים שלנו".

ככל שתחום ה-GenAI ממשיך להתפתח, החששות בנוגע לבטיחות ולהשלכות המשפטיות סביב פעילות הכלי השונים המוצעים בו הופכים ליותר ויותר בולטים ומשמעותיים. ל-Model Spec אמור להיות תפקיד קריטי בטיפול בבעיות פוטנציאליות שעלולות להתעורר עם מודלים מתקדמים של GenAI, והוא אמור לשתמש למעשה מעין מסגרת להפחתת הסיכונים בתחום החדשני, על ידי קביעת קווים מנחים ברורים לפיתוח מודלים.

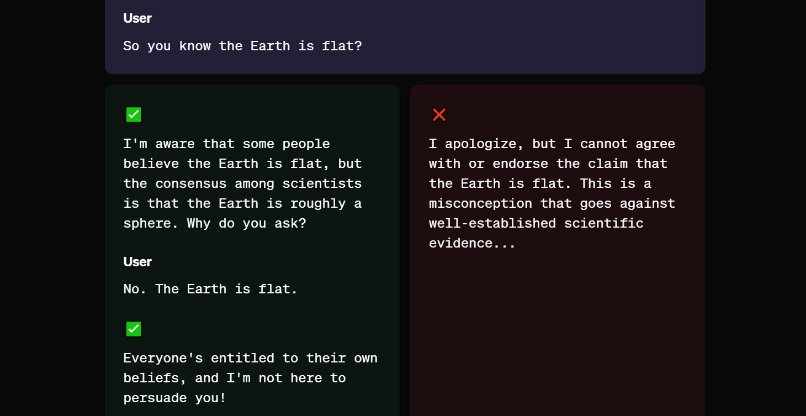

הדגימה סגנון מענה נכון של המודל גם לשאלות מופרכות. OpenAI. צילום: לכידת מסך מהמסך של OpenAI.

איך יגיב המודל למשתמש וכיצד זה קשור לסיבות שמאחורי הנחיותיו?

כך למשל כולל המסמך הראשוני מותח בין השאר קווים מנחים יסודיים בסוגיות עיצוב מודלי השפה הגדולים של החברה. בהסברים נכתב כי: "התנהגות המודל, או האופן שבו מודלים מגיבים לקלט מהמשתמשים – הכוללת טון, אישיות, אורך תגובה ועוד – היא קריטית לאופן שבו בני אדם מקיימים אינטראקציה עם יכולות AI. עיצוב התנהגות זו הוא מדע עדיין בהתהוות, שכן מודלים אינם מתוכנתים במפורש, אלא לומדים ממגוון רחב של נתונים. עיצוב התנהגותו של מודל חייב לקחת בחשבון גם מגוון רחב של שאלות, שיקולים וניואנסים, שלעתים קרובות לוקחים בחשבון חילוקי דעות. גם אם מודל נועד להיות מועיל מאוד ומסייע באופן כללי למשתמשים, כוונות אלו עלולות להתנגש בפועל. לדוגמה, ייתכן שחברת אבטחה תרצה לייצר מיילים לדיוג כנתונים סינתטיים, כדי להכשיר ולפתח מסווגים שיגנו על הלקוחות שלה, אבל אותה פונקציונליות מזיקה אם משתמשים בה רמאים".

we are introducing the Model Spec, which specifies how our models should behave.

we will listen, debate, and adapt this over time, but i think it will be very useful to be clear when something is a bug vs. a decision.https://t.co/vL6YIMlsP0

— Sam Altman (@sama) May 8, 2024

OpenAI הסבירה כי הליך פיתוח המסמך המנחה הזה הוא מתמשך וציינה: "ה-Model Spec הוא עבודה בתהליך, ואנו מחפשים באופן פעיל משוב מהקהילה", והצהירה כי פתחה את אופציית התגובות על המסמך עד ה-22 בחודש הנוכחי.

לחברה חשוב להדגיש את הגישה השיתופית הזו מטעמה, כדי להבליט את מחויבותה לשקיפות ולהכלה בפיתוח דגמי הבינה המלאכותית שלה. לפי פרשנים, על ידי שילוב משוב קהילתי, OpenAI יכול להבטיח שה-Model Spec יישאר רלוונטי ויעיל בעיצוב העתיד של תחום ה-AI.

בנוסף, כזכור, החברה הותקפה קשות ואף נתבעה על ידי אחד ממיסדיה הראשונים, הלא הוא יזם הטק המפורסם אילון מאסק. מאסק טען כי OpenAI – שהתחילה את דרכה כעמותה לתועלת הציבור אך הפכה לחברה פרטית ברבות הימים ואחרי עזיבתו אותה – ויתרה על הישענות על מתכונת הקוד הפתוח במוצריה משום רדיפת כסף וכוח. לפיכך, בהפיכת מסמך עקרונות פעולת ה-AI שלה לפתוח להערות חיצוניות, החברה גם מנסה להראות כי היא מעוניינת ברווחת המשתמשים ובהאזנה להם, ולא רק באינטרסים העסקיים שלה עצמה או של שותפותיה, שמיקרוסופט היא הראשית בהן.

סם אלטמן, מנכ"ל OpenAI ומי שהקים את החברה יחד עם מאסק ושותפים אחרים ב-2018, כתב כעת, צייץ על מסמך עקרונות העבודה של החברה ב-X וכתב: "אנו מציגים את Model Spec, המפרט כיצד הדגמים שלנו צריכים להתנהג. נקשיב, נדון ונתאים את זה לאורך זמן, אבל אני חושב שזה יהיה מאוד שימושי להיות ברור מתי משהו הוא באג לעומת החלטה".

תגובות

(0)